Einfache und komplexe Strukturen der Realität

Inhalt

Vorwort: Überleitung von den abstrakten zu den realen Strukturen

1. Physik und physikalische Strukturen

1.1 Raum und Zeit als relativistische Raumzeit

1.2 Energie und negative Energie: die 4 fundamentalen Wechselwirkungsarten

1.2.1 Kosmologische Energieformen und Energieerhaltung

1.2.2 Die vier fundamentalen Wechselwirkungsarten

1.3 Strukturen im Universum: Entropie, Negentropie, Form, Information und Komplexität

1.3.1 Basale Komplexität und Einfachheit im Universum

1.3.2 Universelle Konstanten der Struktur: Die Naturkonstanten unseres Universums

1.3.3 Die elementare Struktur der Materie - Elementarteilchen

1.4 Systemphysik

1.5 Die physikalisch-kosmologische Evolution unseres Universums

1.5.1 Big Bang, Inflation, "Taschenuniversum"

1.5.2 Entstehung von Strukturen im Raum und Sternenentstehung

1.5.3 Entstehung der chemischen Elemente als verschiedene "Atomarten" (Nukleide)

2. Chemie und chemische Strukturen

2.1 Die chemischen Elemente des Periodensystems

2.2 Die Moleküle und deren Bindungsarten (Atom-, Ionen- und Metallbindung)

2.3 Die Strukturtheorie der Chemie

2.4 Systemchemie

2.5 Die chemische Evolution der Elemente und Moleküle im Universum

2.5.1 Die Bildung chemischer Verbindungen: Molekülbildung in heißen und kalten Plasmen im All

2.5.2 Die Bildung chemischer Verbindungen: Moleküle auf der Erde

2.5.3 Die Entstehung von Festkörpern und Grenzflächen - Kristallchemie

3. Biologie und biologische Strukturen

3.1 Leben und Lebewesen als besondere Form molekularer Selbstorganisation und emergenter Komplexität

3.1.1 Die strukturwissenschaftliche Perspektive in Bezug auf das Leben

3.1.2 Merkmale von biologischen Lebewesen

3.1.3 Leben als besondere Form der Selbstorganisation

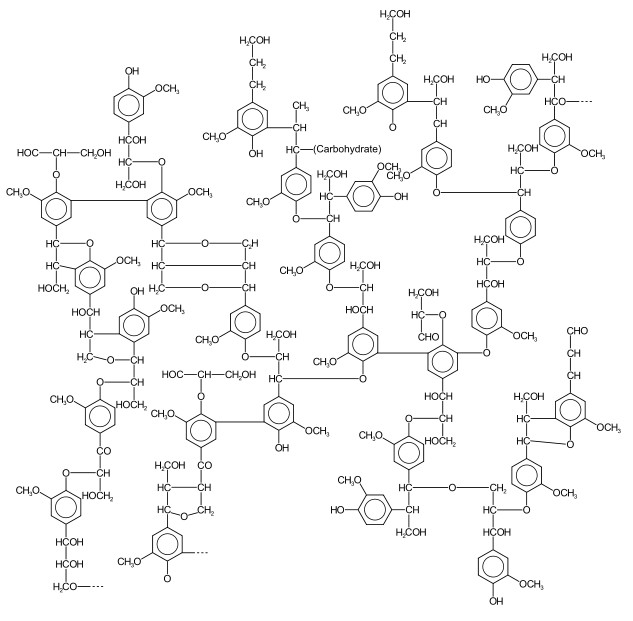

3.1.4 Molekülarchitekturen (hierarchisches Prinzip und kombinatorische Explosion)

3.1.5 Autokatalytische Systeme im Raum

3.2 Der Mensch als komplexes biologisches System

3.2.1 Der einzelne Mensch: Psychologie sinnverarbeitender komplexer biologischer Systeme

3.2.2 Gruppen von Menschen: Soziologie sinnverarbeitender komplexer biologischer Systeme

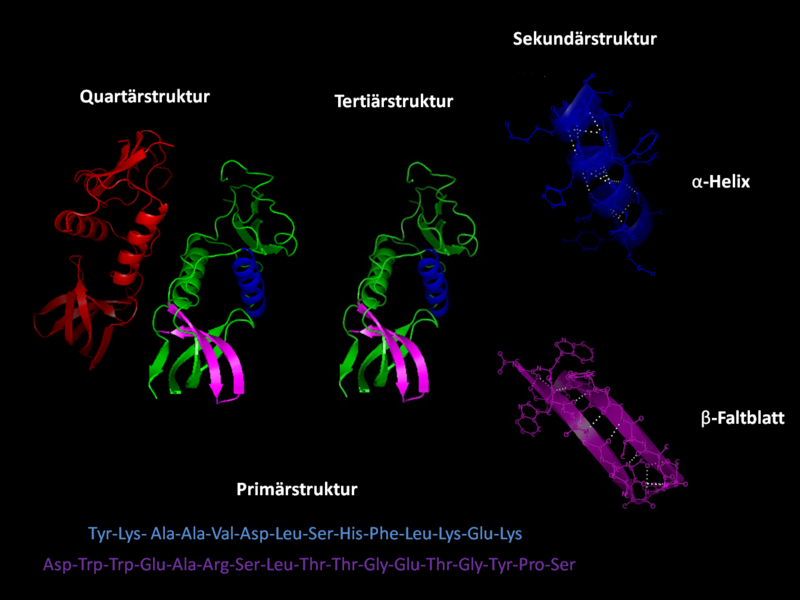

3.3 Strukturbiologie

3.4 Systembiologie

3.4.1 Proteinfaltung

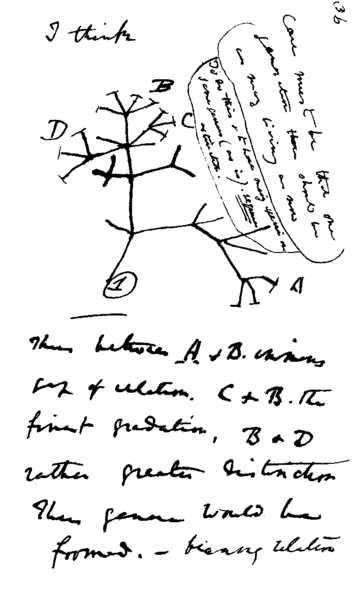

3.5 Die Evolutionstheorie als komplexe strukturwissenschaftliche Theorie des Lebens

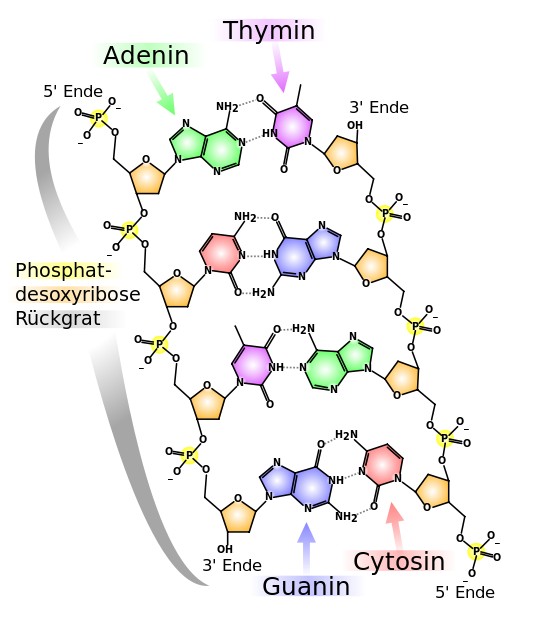

3.5.1 Molekulare Evolution und "RNS-Welt"

3.5.2 Die "Erfindung" der Zelle und Prokaryonten

3.5.3 Eukaryontische Zellen

3.5.4 Vielzeller

3.5.5 Wechselbeziehungen zwischen Organismen

3.5.6 Die Evolution des Menschen als hochkomplexes Säugetier und seine kulturelle Evolution

3.5.7 Künstliche "Evolutionsmaschinen" (Manfred Eigen)

Vorwort: Überleitung von den abstrakten zu den realen Strukturen

"I think the next century will be the century of complexity." 1

Stephen Hawking

Die abstrakten Gebiete der Mathematik, der theoretischen Informatik oder der Systemwissenschaften wurden hier zunächst als strukturwissenschaftliche Kategorien bzw. als Strukturwissenschaften behandelt. Doch wie unterscheiden sich diese eigentlich dann genau von den Naturwissenschaften oder den Sozialwissenschaften?

Früher wurden dazu auch gerne die Begriffe der Formalwissenschaften für die Mathematik bzw. die Realwissenschaften für die Naturwissenschaften verwendet. Ein Nachteil dieser Definitionsform ist die damit implizierte Unterstellung, dass es sich bei der Mathematik (oder Informatik) um keine realen Objekte handelt, was nahelegt, dass es damit dann auch prinzipiell keinerlei Bezüge zur Realität gäbe. Das ist zwar formal gesehen richtig, aber politisch ein wenig unkorrekt, denn darauf kommt es eigentlich auch gerade nicht an.

Wenn man die Wissenschaften als Einheit denkt, dann ist die Unterteilung in Strukturwissenschaft und Naturwissenschaft eher so zu interpretieren, dass es sich bei den Strukturwissenschaften primär um die Erforschung von abstrakten, und bei den Naturwissenschaften um Wissen über reale Strukturen handelt. Vor allem ist es jedoch wichtig zu betonen, dass eine geeignete Auswahl an mathematischen Strukturen brauchbare Modelle liefert, um die Natur zu beschreiben. Daher findet die Strukturwissenschaft unter gewissen Verträglichkeitsbedingungen dann wiederum den Anschluss an die Naturwissenschaften, und ist damit eben nicht eine von der Realität vollständig entkoppelte Wissenschaft.

Wenn wir die Naturwissenschaften dann wiederum aus dem Blickwinkel der Strukturwissenschaften betrachten, so hat die Naturwissenschaft eben gerade nicht die Aufgabe, abstrakte Strukturen und Logiken zu definieren und zu beweisen, sondern muss vielmehr Modelle entwickeln, die zeigen ob und welche Strukturen tatsächlich in der Natur existieren, und wie sich diese per Experiment auch in der Realität nachweisen lassen.

Aus der Sicht der Naturwissenschaftler sind die modellbildenden Verfahren der Mathematiker also zunächst Angebote, die sich möglicherweise als nützlich für die Strukturbeschreibung von Phänomenen in der Natur erweisen könnten. Einige mathematische Methoden werden dabei jedoch vielleicht für immer auf den innermathematischen Bereich beschränkt bleiben, oder Strukturen beschreiben, die in der Natur explizit nicht beobachtet werden können. Diese "Schnittstellenproblematik", d. h. der Umgang mit der Unsicherheit, ob für eine konkrete naturwissenschaftliche Erklärung ein bestimmtes mathematisches Modell nützlich ist, macht diese spezielle "Symbiose" der Wissenschaften dauerhaft interessant und spannend (und natürlich auch risikoreich).

Reale Strukturen unseres Universums - vom Makrokosmos zum Mikrokosmus und wieder zurück

Seit den frei verfügbaren Internet-Technologien, wie beispielsweise Google-Maps, haben wir ein intuitives Verständnis dafür entwickelt, wie es aussieht, wenn man von einem einzelnen Haus ausgehend maßstabsgerecht bis hinaus zur Übersicht über den gesamten Globus heraus- und wieder hineinzoomen kann.

Bildlizenz-Info: verkleinerter Screenshots von

Google Maps

Eine populärwissenschaftliche Zooming-Variante für alle Hobby-Physiker findet man hier online. Dort gibt es ein maßstabsgerechtes Hinein- und Hinauszoomen vom beobachtbaren Universum bis hinunter zu Planck-Länge!

"Bildlizenz-Info: drei verkleinerte Screenshots

der Website, Public Domain

1. Physik

Physik ist die Wissenschaft von den "fundamentalen" Dingen der Natur.

Dazu gehören zunächst einmal der Raum und die Zeit, und weiterhin die Energie (bzw. sein Äquivalent, die Masse).

Auch die elementaren und etwas komplexeren Strukturen der Materie werden untersucht. Im Mikrokosmos sind dies in der Teilchenphysik die Zusammensetzung von Elementarteilchen bis hinauf zum Aufbau ganzer Atome. Im Makrokosmos erforscht die Kosmologie und die Astrophysik die Struktur und die Entstehung des gesamten Universums bis hinunter zu einzelnen Sonnensystemen und Planeten.

Neuere Zweige der Physik beschäftigen sich zunehmend auch mit hochkomplexen (dynamischen) Strukturen und Systemen der Natur, und fragen, welche grundlegenden komplexitätsbildenden Mechanismen es in unserem Universum geben mag.

1.1 Raum und Zeit als relativistische Raumzeit 1

Die Formulierung der Relativitätstheorie gilt als der Beginn der modernen Physik, auch wenn sie häufig als Vollendung der klassischen Physik bezeichnet wird.

Die Relativitätstheorie führte ein völlig neues Verständnis der Phänomene Raum und Zeit ein. Danach handelt es sich nicht um universell gültige Ordnungsstrukturen, sondern räumliche und zeitliche Abstände werden von verschiedenen Beobachtern unterschiedlich beurteilt. Raum und Zeit verschmelzen dabei zur sog. Raumzeit.

Die Zeit bildet dabei die vierte Dimension - neben den klassischen drei räumlichen Dimensionen. Die Gravitation wird auf eine Krümmung dieser Raumzeit zurückgeführt, die durch die Anwesenheit von Masse bzw. Energie hervorgerufen wird. Die Gravitationswirkung auf ruhende Körper wird als konstante Beschleunigung aufgefasst, die Lichtgeschwindigkeit ist absolut und gilt in der Relativitätstheorie als die höchste erreichbare Geschwindigkeit von Objekten innerhalb der Raumzeit.

Die relative Zeit kann sowohl durch die Anwesenheit von Gravitation, als auch durch die jeweilige Geschwindigkeit von Körpern beeinflusst werden. Für Objekte, die sich mit Lichtgeschwindigkeit bewegen, oder in Objekten mit hoher Gravitation (z. B. ein schwarzes Loch) bleibt die relative Zeit stehen.

In der Relativitätstheorie wird auch erstmals die Kosmologie zu einem naturwissenschaftlichen Thema. Auf der Erde vergeht die Zeit einigermaßen "normal-schnell", da wir uns nur mit einem winzigen Bruchteil der Lichtgeschwindigkeit bewegen. Durch die Gravitation vergeht die Zeit auf der Erde jedoch etwas langsamer als (ruhend) im Weltall.

Mit Atomuhren kann man die unterschiedlichen relativistischen Effekte der Raumzeit bereits mit Flugzeugen messen, die einmal mit, bzw. einmal gegen den Drehsinn der Erde fliegen. Aufgrund der Flughöhe und der dortigen geringeren Gravitation vergeht die Zeit zunächst etwas schneller, aufgrund der Geschwindigkeit dann in Summe jedoch wieder langsamer als für den ruhenden Beobachter auf der Erde. Diese Messungen, welche die Ergebnisse der Relativitätstheorie bestätigen, bilden die Grundlage aller derzeit im Einsatz befindlichen GPS-Systeme (also auch der Navigationssysteme in unseren Autos). GPS-Systeme messen nämlich nicht den Ort, sondern die Zeitdifferenz der einzelnen, sich mit hoher Geschwindigkeit und die Erde bewegenden, GPS-Satelliten zueinander und bestimmen damit indirekt den jeweiligen Ort des Beobachters.

In der allgemeinen Relativitätstheorie, deren Gültigkeit durch eine Vielzahl von Experimenten bestätigt wird, sind Raum und Zeit unauflöslich miteinander verknüpft. Der Raum kann dort sogar durch die Gravitation gekrümmt werden. Doch man kann den Raum nicht krümmen, ohne die Zeit einzubeziehen. Die Zeit hat damit gewissermaßen selbst eine Form.

Besonders interessant ist das Wechselspiel zwischen Raum, Zeit, Massen und Gravitation. Denn durch die Krümmung von Raum und Zeit macht die allgemeine Relativitätstheorie aus diesen einst passiven Elementen eines Hintergrunds aktiv-dynamische Teilnehmer des Geschehens! Raum und Zeit existieren dabei weder unabhängig voneinander, noch sind sie unabhängig von dem Universum und dessen Elementen. In der klassischen Physik hingegen waren sowohl der Raum als auch die Zeit unabhängige Objekte, die gleichsam ein Bühne als Hintergrund für die sich darin abspielenden Vorgänge darstellte.

Der Minkowski-Raum der speziellen Relativitätstheorie

Der flache Minkowski-Raum der speziellen Relativitätstheorie beschreibt zunächst eine vierdimensionale Raum-Zeit ohne Gravitation. In der Konvention, die hauptsächlich in der Allgemeinen Relativitätstheorie eingesetzt wird, besitzen diese vier Dimensionen unterschiedliche Vorzeichen. Die vierdimensionale Notation (Zeit, Raumkoordinate x, Raumkoordinate y , Raumkoordinate z) besitzt die Vorzeichen (-1, 1, 1, 1). Zu beachten ist daher, dass die Zeit stets das umgekehrte Vorzeichen, wie der Raum besitzt. Zeit ist damit quasi "negativer Raum".

Allgemeine Relativitätstheorie

In der Allgemeinen Relativitätstheorie (ART) geht die jeweilige Raumkrümmung, die durch lokale Gravitationskräfte hervorgerufen wird, und an jedem Ort des Universums verschieden sein kann, mit in die Feldgleichungen ein.

Dadurch dass Gravitation jedoch wiederum von Masse bzw. auch von massebehafteter Materie verursacht wird, entsteht in der ART eine Verschachtelung bzw. Koppelung von Raum, Zeit, Gravitation und Masse. Im Gegensatz zur klassischen Physik sind diese physikalischen Grundgrößen nun nicht mehr als unabhängig voneinander zu betrachten.

Aus Sicht der Komplexitätsforschung liegt hiermit dann bereits eine fundamentale Integration und komplexe Verschachtelung vor. Sie ist jedoch erst der Anfang von Komplexität und Struktur im Universum.

1.2 Energie und negative Energie: die 4 fundamentalen Wechselwirkungsarten

1.2.1 Die kosmologischen Energieformen und die kosmologische Buchhaltung der Energieerhaltung

In unserem Universum kennen die Kosmologen drei basale Energieformen:

- Zum ersten gibt es die Energie von Strahlung (eine relativistische Energieform) und der Materie (inklusive der sogenannten dunklen Materie), welche expansiv im Universum wirkt.

- Zum zweiten gibt es als Gegenkraft die Gravitationsenergie, die zum Abbremsen der Expansion durch gegenseitige Anziehung führt.

- Zum dritten gibt es noch die sogenannte dunkle Energie, die zur beschleunigten Ausdehnung der Raumzeit führt.

Als nächstes könnte man fragen, wie groß eigentlich die Energiemenge des Universums ist?

Da Energie eine Erhaltungsgröße ist, kann sie per Definition weder erzeugt, noch vernichtet werden, da sich dahinter fundamentale Symmetrieprinzipien verbergen. Interessanter Weise kann man heutzutage jedoch Modelle formulieren, die eine große mathematische Eleganz besitzen und zeigen, dass die Gesamtenergie des heutigen und früheren Universums exakt gleich Null ist! Zum Verständnis muss man zunächst wissen, dass die Gravitationsenergie ein negatives Vorzeichen besitzt.

Damit kann man dann folgende Gleichung formulieren, bei der die Summe stets Null ergibt:

Energie(Strahlung) + Energie(Materie) + Energie(dunkle Energie) + - Energie(Gravitation) = 0

oder kürzer:

Energie(Strahlung, Materie, dunkle Energie) - Energie(Gravitation) = 0

oder als Bilanzgleichung:

Energie(Strahlung, Materie, dunkle Energie) = Energie(Gravitation)

Man kann demnach sagen, dass unser Universum zu keiner Zeit den Energieerhaltungssatz verletzt, da die Energiesumme, also die Integration aller Energieformen, immer Null ist, egal wie groß die jeweiligen absoluten Bilanzsummen sind. Diese Aufhebung durch Inversion ist ein raffinierter Trick, um ein Universum mit beliebig viel Energie (und Antienergie) buchstäblich aus dem Nichts zu erschaffen. Statt also die Energie irgendwoher zu holen, oder den Energieerhaltungssatz zu verletzen, können wir die Energieformen in unserem Universum in Summe auch lediglich als eine recht interessant ausbalancierte Variation von Nichts betrachten.

Negative Energie?

Aber warum ist ausgerechnet die Gravitationsenergie eigentlich negativ? Mathematisch gesehen erklärt sich das so: Wenn man eine kugelförmig verteilte Masse von einem großen Radius durch die gegenseitige Anziehung in einen kleineren Radius überführt, dann steigt die Gravitationsenergie, aber beim Zusammenziehen auf den kleineren Radius hin wird jedoch Arbeit verrichtet, die der Gravitationsenergie verloren gehen muss. Deren Abnahme ist mit der Zunahme ihres Betrages jedoch nur vereinbar, wenn sie negativ ist. D. h. die Gravitationsenergie geht beispielsweise beim Zusammenziehen somit von dem Wert -1 auf -2 zurück, ihr Betrag wird also größer, während die Energiemenge kleiner wird (quasi "mehr negativ").3

Die Entwicklungsmodelle von Energie und negativer Energie

Interessant ist daher nun auch die Frage, wie sich eigentlich diese speziellen Formen von energetischem "Nichts" im Verlaufe der kosmologischen Evolution entwickelt haben, so dass wir letztendlich beispielsweise tagtäglich die Energiestrahlen unserer Sonne genießen können.

Während wir in der heutigen materiedominierten Phase unseres Universum nicht nur von Energieerhaltung, sondern auch von einem konstanten absoluten Betrag der Materieenergie (und analog der Gravitationsenergie) sprechen können, so galt dies in der Frühphase des Universums noch nicht. Die jeweiligen Beträge (die in Summe natürlich zu jederzeit Null ergeben müssen) werden bei einem räumlich flachen Universum nach den Einsteinischen Feldgleichungen, bzw. deren Spezialisierung auf unser Universum (Friedmann-Lemaitre-Gleichung) beschrieben.

Bei den einfachsten Urknallmodellen ohne Inflation steigen die Energiebeträge zum Urknall hin kontinuierlich an, um in der Urknallsingularität schließlich ins Unendliche zu divergieren. Gleichzeitig wird dann auch die Gravitationsenergie minus Unendlich groß.

In der modernen Kosmologie werden die Urknallsingularitäten dadurch vermieden, dass man vor dem eigentlichen Urknall von einer Phase der explosiven Expansion (der Inflation) ausgeht. Diese Inflation wurde durch dunkle Energie sehr hoher, aber endlicher Konzentration angetrieben. Zu Beginn der Inflation war die Gesamtmenge an dunkler Energie wegen der mikroskopischen Kleinheit des Universums auch verschwindend klein, nahm jedoch aufgrund der schnellen Expansion trotz abnehmender Konzentration sehr schnell zu. Wegen der Erhaltung der Summe aller Gesamtenergien musste das durch eine gleich schnelle Zunahme des Betrags der Gravitationsenergie kompensiert werden. Die Phase der Inflation wurde dadurch beendet, dass die dunkle Energie in einer Art Phasenübergang durch den Zerfall in Energie von Strahlung und Materie überführt wurde. Die heutzutage vorhandene gewaltigen Mengen an Strahlung und Materie (also die für uns nutzbaren Energieträger) stammen letztlich aus der dunklen Energie, einer Art energiereichem Vakuumszustand der Quantenphysik, der dort auch "falsches Vakuum" genannt wird.4

Da jedoch die Gesamtmenge der dunklen Energie anfänglich verschwindend gering war, kann man durchaus sagen, dass die derzeit für unsere Zwecke zur Verfügung stehende Energie des Universums buchstäblich aus dem Nichts kam, und interessanter Weise sogar ohne den Energieerhaltungssatz zu verletzen. Ein echter "Big Trick" also!

Zur heutigen kosmologischen Energieverteilung ist zu sagen, dass die Gesamtmenge der positiven Energie unseres Universums zu 68% aus dunkler Energie, zu 27% aus dunkler Materie, zu 4% aus baryonischer Materie und zu 1% aus Strahlung besteht. Zum einen ist es daher recht erstaunlich, dass der für uns relevante Anteil der Energieformen, aus denen wir letztendlich auch selbst bestehen, lediglich 5% ausmacht, also fast schon als kleiner "Dreckseffekt" abgetan werden kann, und auf der anderen Seite die anderen 100%, also die 100% negativer Energie, einzig der Gravitation zuzuschreiben sind. Damit ist sie die wahre Energie-Herrscherinn im Universum, und das, obwohl ausgerechnet die Gravitation die schwächste aller 4 Wechselwirkungsarten ist. Nun ja, die Gravitation ist eben eine bescheidene Herrscherin.

1.2.2 Die vier fundamentalen Wechselwirkungsarten: Gravitation, elektromagnetische Wechselwirkung, starke und schwache Wechselwirkung

Die relativen Stärken der vier Wechselwirkungsarten unseres Universums sind heute, also nach 13,8 Milliarden Jahren, sehr unterschiedlich. Sie liegen nämlich, nach Stärke absteigend sortiert, im Verhältnis 1 : 0,0073 : 5*10-14 : 2*10-39 (starke Kernkraft, elektromagnetische Wechselwirkung, schwache Kernkraft und schließlich die Gravitation) vor. Die Gravitationskraft ist also fast 40 Größenordnungen kleiner als die starke Kernkraft!

Man geht jedoch heutzutage von einem gemeinsamen Ursprung aller vier Kräfte aus, die im ersten Moment der Universums-Entstehung nahezu gleichstark gewesen sein sollen. Die Hochenergiephysik kann zeigen, dass sich zunächst die schwache Kernkraft mit der elektromagnetischen Kraft bei hohen Energien (Temperaturen) vereinen lässt. Diese werden dann ununterscheidbar. Weiterhin geht man davon aus, dass bei noch höheren Energien dies auch mit der starken Kernkraft und der Gravitation passiert. Umgekehrt sind demnach bei der Entwicklung des Universums während seiner Abkühlung dieser vier Wechselwirkungsarten bei spontanen Symmetriebrüchen quasi auseinandergebrochen, und liegen nun in höchst unterschiedlichen relativen Stärken vor.

1.3 Strukturen im Universum: Entropie, Negentropie, Form, Information und Komplexität

1.3.1 Basale Komplexität und Einfachheit im Universum5

Gibt es ein Komplexitätserhaltungsgesetz?

Die Suche nach den Ursachen der vielfältigen Muster der Natur führt die Mathematik und uns derzeit in gedankliches Neuland.

Früher war man sicher: Das Universum mag kompliziert wirken, aber es gehorcht einfachen mathematischen Gesetzen. Die Regelmäßigkeiten in der Natur belegen angeblich die Einfachheit dieser Gesetze. Heute hingegen mehren sich die Anzeichen, dass der Zusammenhang zwischen Gesetzen und Mustern - zwischen Ursache und Wirkung - nicht immer so geradlinig ist.

Wäre diese Beziehung tatsächlich so eindeutig, dann müssten einfache Gesetze unter einfachen Umständen stets zu einfachen Mustern führen, und komplizierte Gesetze in komplexen Szenarien brächten immer komplexere Muster hervor. Es gäbe also eine regelrechtes "Komplexitätserhaltungsgesetz", dem zufolge die Einfachheit respektive Komplexität einer Ursache zwangsläufig an die aus ihr folgende Wirkung weitergegeben würde.

Eine solche Vorstellung erscheint heute nicht mehr haltbar, doch bis zu dieser Einsicht ist viel Zeit vergangen, da unsere Denkstrukturen für ein derartiges Prinzip wie geschaffen erscheinen. Wir fragen gerne danach, woher Einfachheit und Komplexität kommen, als ob diese Eigenschaften irgendwo anders ihren Ursprung nähmen, und dann auf die Objekte unseres Interesses übertragen würden. Wir sind daher normalerweise damit zufrieden, dass das einfache Gravitationsgesetz für einfache, elliptische Umlaufbahnen sorgt, und wären verstört, wenn ein so simples Gesetz höchst verwickelte und unordentliche Bahnen erzeugen würde oder wenn umgekehrt diese einfachen Ellipsen aus einem furchtbar komplizierten Gravitationsgesetz folgten.

Die derzeit an den Grenzen unseres Wissens operierenden strukturwissenschaftlichen Forscher haben erkennen müssen, dass einfache Ursachen oft komplexe Wirkungen hervorrufen können und komplexe Ursachen häufig einfacher Effekte haben. Allerdings ist der Weg zum Einfachen - um die paradoxe Anmutung zu wahren - höchst kompliziert.

Eines der neuartigen mathematischen Systeme, die uns zum Umdenken gezwungen haben, ist das bereits im Informatik-Bereich erwähnte "Game of Life", also ein zellularer Automat. Ein solches System zu programmieren, im Computer laufen zu lasen und zu beobachten, ist einfach. Die Ergebnisse umfassend zu interpretieren, erweist sich als viel schwieriger - oft sogar als unmöglich. Wir sehen einer Startanordnung zum Beispiel nicht an, ob die Regeln schließlich zur Auslöschung aller Quadrate führen. Es gibt keine allgemeine Lösung für das Problem. Die Mathematik verrät uns lediglich, dass die Beantwortung dieser Frage nicht in ihrer Macht liegt und ein unentscheidbares Problem vorliegt. Eine noch komplexere Wirkung einfachster Ursachen kann man sich kaum vorstellen.

Unsere Intuition versagt hier also jämmerlich: Komplexität kann aus einfachen Regeln erwachsen; sie muss nicht bereits in die Regeln eingebaut sein. Umgekehrt können Systeme, die aus der Nähe betrachtet ungeheuer kompliziert wirken, im Großen recht einfache Verhaltensmuster an den Tag legen. Solche Emergenzphänomene zu verstehen, ist das Ziel eines neuen Mathematikzweiges: der Theorie komplexer adaptiver Systeme.

So etwas wie eine Komplexitätserhaltung scheint es daher sowohl in der Mathematik, als auch im Universum nicht zu geben.

Stetigkeit? Bifurkationen und Phasenübergänge (Katastrophentheorie)

Unsere Intuition möchte uns oft auch weismachen, dass kleine Veränderungen auf der Ursachenseite auch nur kleine Veränderungen in der Wirkung zur Folge haben könnten. Doch die Überzeugung, kleine Schritte könnten auch nur kleine Veränderungen bewirken, ist ebenso irrig wie die Vorstellung von der Komplexitätserhaltung. Nun ja, nicht ganz: Normalerweise rufen kleine Veränderungen in der Ursache tatsächlich nur kleine Veränderungen in der Wirkung hervor, aber manchmal kann eine kleine Abweichung in der Ursache auch gewaltige Folgen zeigen. Es ist in etwa so, wie bei dem durch eine Redewendung so berühmten Tropfen, der das Fass zum überlaufen bringt.

Solche Effekte, also abrupte Veränderungen von Systemen, die sich in einem kritischen Zustand befinden, nennt man Bifurkationen, oder mathematisch auch Katastrophen. In den 1960'er Jahren entstand dazu eine neue mathematische Disziplin, die Katastrophentheorie von René Thom. Sie ist in der Sprache der Differentialtopologie geschrieben und versucht, ein wenig Ordnung und Struktur in derartige Probleme zu bringen. Sieben archetypische Elementarkatastrophen kennt diese mathematische Disziplin. Doch das Wort "Katastrophe" ist in der Wissenschaft ein wenig aus der Mode gekommen. Zu Recht, denn hängt ihm doch der unpassende Beigeschmack von großem Unheil an. Heute bevorzugt man in der Theorie der dynamischen Systeme eher den Begriff der "Bifurkation". Wenn sich der Zustand eines Systems infolge einer kleinen externen Variation dramatisch ändert, sagt man daher, es habe eine Bifurkation stattgefunden. Die Bifurkationstheorie ist mittlerweile ziemlich ausgereift und aussagekräftig, sodass man mit ihrer Hilfe abrupter Änderungen in den unterschiedlichsten Systemen verstehen kann.

In der Physik kennt man solche Bifurkationen zu Genüge. Dort nennt man sie "Phasenübergänge". Einer der bekanntesten Phasenübergänge ist sicherlich das Gefrieren von Wasser unterhalb von Null Grad Celsius oder auch das Sieden von Wasser bei 100 Grad Celsius.

Auch die Kristallbildung gehört zu den Phasenübergängen. Doch warum bildet die Materie überhaupt unterscheidbare Phasen aus? Durch das Studium stark vereinfachter mathematischer Modelle haben die Physiker viel über Phasenübergänge gelernt. Das bekannteste Modell ist dabei das Ising-Modell des Physikers Gustaf Ising, und besteht aus einem zweidimensionalen Gitter. Wie sich herausstellte, gibt es eine genau berechenbare kritische Temperatur, bei der sich das Spin-Muster abrupt ändert, also eine Bifurkation stattfindet. Diese Phasenübergänge gehen mit einer Veränderung der Symmetrieverhältnisse im Material einher, aber es handelt sich um eine eigentümliche Form der Symmetrie: um statistische Symmetrien der Eigenschaftswerte, nicht etwa der einzelnen Komponenten.

Eine Erhaltung der Stetigkeit als "Stetigkeitserhaltungsgesetz" scheint es daher ebenfalls nicht zu geben. Bifurkationen sind in der Mathematik und im Universum mindestens genauso elementar.

Gibt es ein Symmetrieerhaltungsgesetz? Symmetrie und Symmetriebrechung

Kommen wir nun zum Thema der Symmetrie. Gibt es ein "Symmetrieerhaltungsgesetz"? Symmetriebetrachtungen sind in vielerlei Hinsicht der mathematischer Kern der Überlegungen zum Thema Einfachheit und Komplexität. Symmetrieveränderungen werfen dabei Fragen auf, die in allen modernen Musterbildungstheorien eine zentrale Rolle spielt. Einmal mehr müssen wir uns dazu jedoch von einigen liebgewonnenen Vorstellungen verabschieden.

Der Physiker Pierre Curie, der zusammen mit seiner Frau Marie das Radium entdeckt hatte, stellte 1894 folgendes physikalisches Prinzip auf: Symmetrische Ursachen führen auch zu symmetrischen Wirkungen. Hat man es umgekehrt mit asymmetrischen Phänomenen zu tun, sollte man nach einer asymmetrischen Ursache Ausschau halten.

Heutzutage wissen wir, dass dieses Prinzip nicht immer gilt. Es gibt nämlich auch Wirkungen, die weniger symmetrisch sind, als ihre Ursachen. Dieses Phänomen wird als Symmetriebrechung bezeichnet. Zu seiner Erklärung müssen wir ein weiteres Konzept einführen: Stabilität. Und wir müssen Curies Prinzip folgendermaßen abwandeln: Symmetrische Ursachen haben gleichermaßen symmetrische Wirkungen, sofern die so erzeugten Zustände nicht instabil sind - andernfalls wird die Symmetrie gebrochen.

Doch wohin entschwindet die Symmetrie eigentlich, wenn sie bricht? Genau genommen muss sie nirgends hingehen. Weder Komplexität noch Stetigkeit werden erhalten, warum also sollte Symmetrie erhalten werden? Aber sie wird ausnahmsweise tatsächlich erhalten - gewissermaßen.

Nehmen wir als Beispiel einen Bleistift, den wir auf seine Spitze stellen. Dies ist ein höchst instabiler Zustand, und sobald wir ihn loslassen, wird er zufällig in irgendeine Richtung fallen und derart ausgerichtet auf dem Tisch liegen bleiben. Dieser Bleistift, der nun in eine bestimmte Richtung zeigt, ist viel unsymmetrischer, als das symmetrische Gravitationsgesetz, aus dem er hervorgegangen ist. Diesem Bleistift sieht man sozusagen die Symmetrie der Gravitation nun nicht mehr an. Doch was passiert, wenn ich eine Vielzahl an Fallversuchen mache, und die Ergebnisse dann aufaddiere? In Summe verteilen sich nun die Richtungen des Bleistiftes gleichmäßig und ergeben zunehmend in Summe eine Kreisform. Und siehe da: schon ist die ursprüngliche Symmetrie wiederhergestellt!

Ein Mathematiker formuliert dies dann so: Wenn man eine Lösung des Gleichgewichtssystems nimmt und sie im Raum dreht, erhält man weitere, ebenso zulässige Lösungen. Wenn man wüsste, dass es nur eine einzige Lösung gibt, hätte Curie mit seiner Symmetrieerhaltung Recht. Aber dynamische Gleichungen haben jede Menge Lösungen - und dies ist auch des Rätsels Lösung. Kurz gesagt können einzelne Lösungen die Symmetrie des Ausgangssystems brechen, aber die Summe aller Lösungen bleibt symmetrisch. Die Symmetrie wird gewisser Maßen über eine ganze Reihe Lösungen "verschmiert". Und der Auslöser dieses Verteilungsvorganges ist das Einsetzen der Instabilität der symmetrischen Lösung.

Von der Symmetrie und der Symmetriebrechung zur Form hat unseres Universums

Symmetrie erleichtert die Lösbarkeit von Gleichungen, da sie deren Komplexität vermindert. In drei Dimensionen ist sphärische Symmetrie so ziemlich das Einfachste, was überhaupt noch eine interessante Struktur zulässt. Daher ist es nicht verwunderlich, dass die Physiker zunächst nur mit sphärischen symmetrischen Lösungen aufwarteten, als sie sich daranmachten, Einsteins Gleichungen über die Form und die Dynamik des gesamten Universums zu lösen.

Es brauchte eine ganze Zeit, bis auch andere Modelle über die Form des Universums entstanden. Doch "Form" ist nicht ganz das richtige Wort. Der Begriff Form beschreibt, wie sich der Teil, den das Objekt einnimmt, zum Raumganzen verhält. Aber das Universum ist das Ganze. Und wir sitzen in ihm drin, so dass wir es nicht aus der nötigen Distanz betrachten können.

Doch Mathematiker sind an derartige Schwierigkeiten gewöhnt. Wenn sie sich auf sinnvolle Weise über den Abstand zwischen Punkten in einem mathematischen Objekt verständigen können, dann hat das Objekt für sie so etwas wie eine Form: es ist die Gesamtheit aller Abstände zwischen allen Punkten. Dieser Formbegriff verzichtet auf eine Außenperspektive; es geht nicht mehr darum, wie ein Objekt in seine Umgebung eingebettet ist.

Einstein zufolge ist beispielsweise die Gravitation keine Kraft, sondern eine Folge der Krümmung der Raumzeit. Für den Mathematiker ist eine Ebene Flach, eine Kugel hat eine positive, und ein Trichter eine negative Krümmung. Die Krümmung der Raumzeit können wir messen, indem wir ermitteln, wie stark die Gravitation das Licht ferner Galaxien ablenkt. Insbesondere in der Nähe von Schwarzen Löchern sollte sie sehr groß werden. Und Schwarze Löcher soll es laut den Astronomen unzählige geben, beispielsweise auch im Zentrum unserer eigenen Galaxie. Unser Universum ist demnach ein wenig wie ein Schweizer Käse geformt, voller Löcher. Dies verrät uns aber noch nicht, ob das Universum als Ganzes kugelig, flach, zylindrisch oder torusförmig ist. Um das herauszufinden muss man sich die Geometrie der Raumzeit viel genauer ansehen. Das bevorzugte Erklärungsmodell der Kosmologen geht heutzutage von der sogenannten Inflationstheorie aus, woraus das Universum insgesamt gesehen als extrem flach hervorgegangen sein soll.

Doch Symmetriebetrachtungen führen uns auch in vertiefender Weise zu den Naturgesetzen des Universums und deren Charakter.

Symmetrische Gesetze ...

Einstein hatte ein ganz besonderes Gespür für die grundlegende Einfachheit der Natur, und er begründete seine Ansichten über die Physik auf einem Symmetrieprinzip. Die Symmetrietransformationen in der Raumzeit dürfen die Naturgesetze nicht antasten. Relativität ist eine Ausarbeitung dieses Prinzips im Kontext des Elektromagnetismus und der Gravitation, zweier Schlüsselkräfte für das Verhalten von Materie.

Zu diesen beiden Kräften haben sich dank der Quantentheorie noch zwei weitere gesellt (die starke und die schwache Wechselwirkung) und außerdem eine ganze Reihe von Symmetrieprinzipien. Diese erlegen den Gesetzen der Quantenphysik auf dieselbe Weise Beschränkungen auf, wie es die Symmetrien der Raumzeit mit der Relativität tun. Manche der Symmetrien sind recht anschaulich: Spiegelbildlichkeit, Zeitreversibilität (Umkehrbarkeit des Zeitpfeils) und die Ladungskonjugation (Parität), durch die sich die Vorzeichen elektrischer Ladungen umkehren. Andere, etwas unanschaulichere, kommen nur in der Mathematik der Quantenwelt zum Ausdruck.

Das Herz der Quantentheorie ist die Teilchenphysik, welche die kleinsten Bausteine der Materie zu ergründen versucht. Zunächst schien es so, als ob die Anzahl der Elementarteilchen recht überschaubar wäre. Protonen, Neutronen und Elektronen. Doch dann verlängerten die Experimentalphysiker durch Experimente in Teilchenbeschleunigern die Liste ganz erheblich.

Unter elementaren Teilchen verstehen Physiker dabei grundsätzlich winzige Partikel ohne messbare innere Struktur. Doch neben den Elementarteilchen gibt es auch noch verschiedene Arten von Objekten, die aus mehreren Elementarteilchen zusammengesetzt sind, die Hadronen. Da diese jedoch bereits zusammengesetzte Objekte sind, entstand gerade dort eine unüberschaubare Vielfalt an Teilchen. Doch im Jahre 1964 entwickelte der Physiker Murray Gell-Mann das Quarks-Modell, wonach sich die Hadronen sinnvoll klassifizieren lassen.

Vorausgegangen war eine Entdeckung im Jahre 1962, wonach die Hadronen eine schöne innere Symmetrie aufweisen. Indem man die mathematischen Gleichungen für diese Partikel gemäß einer Symmetrie transformiert, die als SU(3) bezeichnet wird, kann man ein Proton quasi so "umklappen", dass es zum Neutron wird. Das heißt, man kann die Gleichungen für ein Proton in die Gleichungen für ein Neutron verwandeln. Der Natur wurde somit eine fundamentale und exotische innere Struktur nachgewiesen, in der sogar Elementarteilchen ihre Identität wechseln können.

Die Liste physikalischer Symmetrien in Bezug auf die fundamentalen vier Wechselwirkungsarten ist jedoch sogar noch etwas länger und wird in der Gruppentheorie mit Hilfe von unitären Gruppen "U" und speziellen unitären Gruppen "SU", sowie den speziellen orthogonalen Gruppen "SO" beschrieben:

- lokale U(1)-Symmetrie des Elektromagnetismus

- globale und lokale Isospin-Symmetrie SU(2)

- globale und lokale SU(3)-Symmetrie der starken Wechselwirkung

- SO(4)-Symmetriegruppe des H-Atoms

Jenseits des Standardmodells der Teilchenphysik findet man weitere hypothetische Symmetriegruppen, wie:

- SU(5) für die Vereinigung der elektroschwachen und der starken Kernkraft

- Supersymmetrie (SUSY) durch Spiegelung aller bekannten Elementarteilchen

... für ein symmetrisches Universum?

Bei den tiefsten physikalischen Symmetrien geht es den Physikern jedoch gar nicht um die Beschreibung des heutigen Universums. Diese Symmetrien beschreiben entweder seinen Zustand kurz nach dem Urknall, oder sind reine Mathematikererfindungen, die keiner Beobachtung in der Realität entsprechen.

Entstanden ist diese Problematik durch die Entdeckung, dass einige der im Universum scheinbar herrschenden Symmetrien gelegentlich versagen: Sie können gebrochen werden. Dies wurde erstmals 1956 deutlich, als theoretische Physiker (Tsung-Dao Lee und Chen-Nin Yang) die Vermutung äußerten, dass die schwache Wechselwirkung die Spiegelsymmetrie verletzt, und Experimentalphysiker bewiesen, dass dem tatsächlich so ist.

Die Gesetze, denen unser Universum gehorcht, unterscheiden sich also von den Gesetzen einer hypothetisch spiegelbildlich aufgebauten Welt.

Doch die Asymmetrie ist relativ schwach. Vielleicht ist daher unser Universum lediglich eine leichte Variation eines perfekt symmetrischen Universums. Doch einige attraktive mathematische Urknallmodelle laufen sogar auf eine noch elegantere Lösung des Problems hinaus. Diese behaupten, dass früher (also kurz nach dem Urknall) alle vier Kräfte eins waren. Aber dann hatte nach der glühenden Hitze des Urknalls durch eine Reihe von Symmetriebrüchen, die in der Physik Phasenübergänge genannt werden, die Aufspaltung der einen Kraft in schließlich vier stattgefunden, welche heute nun ganz unterschiedliche Eigenschaften (z. B. relative Kräfteverhältnisse) besitzen.

Mathematisch gesehen waren daher die Gesetze jenes frühen Universums einfacher und eleganter als diejenigen unserer heutigen Welt. Und auch wenn einige der Symmetriebrüche noch physikalische Spekulation sind, so ist eines jedoch bereits ganz klar nachgewiesen worden: In den allerersten Augenblicken nach dem Urknall erfuhr unser Universum noch eine andere Symmetriebrechung. Die Materie war anfangs gleich verteilt, bildete jedoch schon bald Klumpen, also verschieden starke Ansammlungen von Materie im Raum. Diese Materiehaufen waren die erste Vorstufe der heutigen Galaxien, Sterne und Planeten.

Die zunächst noch recht bescheidene Ungleichverteilung reichte jedoch aus, um später bei der Ausdehnung und Abkühlung jenes fraktale Netzwerk aus leeren und massereichen Regionen entstehen zu lassen, das wir heute im Universum vorfinden. Abseits dieser Haufen ist das Universum jedoch ziemlich plan, was -wie schon erwähnt- derzeit durch die Modelle der Inflationstheorie erklärt wird.

1.3.2 Universelle Konstanten der Struktur: Die Naturkonstanten unseres Universums

In einem Universum, in dem durch die Evolution nichts so beständig wie der Wandel ist, könnte man sich zunächst durchaus fragen, ob es überhaupt irgendwelche Dinge gibt, die konstant sind. Physiker nennen diese fundamental konstanten Parameter auch Naturkonstanten. Die mathematische Definition einer Struktur sagt, dass jede Struktur aus einer Menge, Konstanten, Relationen und Funktionen besteht. Die Anzahl der Konstanten kann dabei von Null bis unendlich reichen. Die Physiker versuchen daher in ihren Modellen, möglichst wenig dieser Naturkonstanten zu benötigen, da ein solcher Parameter nicht aus den Theorien hergeleitet werden kann, sondern den Messergebnissen angepasst werden muss.

Die Anzahl an benötigten Naturkonstanten, die sogenannten "freien Parameter" der aktuellen Teilchenphysik und der Kosmologie, ist derzeit leider noch recht groß. Rund 40 Naturkonstanten werden dort benötigt. Da man jedoch davon ausgehen kann, dass die derzeitigen Modelle noch nicht der Weisheit letzter Schluss sind, gibt es auch vielfach die Meinung, man könne mit der eines Tages zur Verfügung stehenden "Theorie für Alles" mit erheblich weniger Naturkonstanten auskommen. Im Idealfalle vieleicht sogar mit Null.

Die freien Parameter des derzeitigen Standardmodells der Teilchenphysik lauten:

- 3 Kopplungskonstanten, d.h. Maßzahlen für die Stärke der 3 Wechselwirkungen (ohne Gravitation)

- 6 Massen der Quarks

- 6 Massen der geladenen Leptonen und der Neutrinos

- 4 Winkel zur Beschreibung von Quarkzerfällen (3 reelle und 1 komplexer Mischungswinkel)

- 4 Winkel zur Beschreibung von Neutrinomischungen (3 reelle und 1 komplexer Mischungswinkel)

- 1 Winkel zur Beschreibung der "CP Verletzung" in der starken Wechselwirkung

- 1 Masse des Higgs Teilchens

- 1 Vakuum-Erwartungswert des Higgsfeldes

Summe: 26 Parameter

Die freien Parameter des Standardmodells der Kosmologie (Konkordanzmodell) bestehen aus:

- 1 Hubble-Konstante (Galaxienflucht)

- 1 baryonische Dichte

- 1 Dichte der dunklen Materie

- 1 Dichte der dunklen Energie

- 1 skalare Massenfluktuationsamplitude

- 1 skalarer spektraler Index

- 1 Raumkrümmung (Omega k, Wert annähernd Null)

- 1 Expansionsalter des Universums (13,8 Milliarden Jahre)

- 1 Alter der ältesten Sterne (400 Millionen Jahre nach dem Urknall)

- 1 Gravitationskonstante

- 1 Lichtgeschwindigkeit

Summe: 11 Parameter

Wenn wir zu diesen 37 Parameteren dann noch die 3 Raumdimensionen und die eine Zeitdimension addieren und zu guter letzt noch das Plancksche Wirkungsquantum, dann sind wir sogar schon bei 42 freien Parametern.

1.3.3 Die elementare Struktur der Materie - Elementarteilchen und das Atom

Bildlizenz-Info: Wikimedia, Schimaticky atom, public domain

Insbesondere durch Experimente an Teilchenbeschleunigern wissen wir heute, welche komplexe Struktur die Atome, die man lange Zeit als unteilbar annahm, besitzen.

Zunächst besteht das Atom aus einer negativ geladenen Elektronenwolke und einem vergleichsweise kleinen positiv geladenen Atomkern, der aus Nukleonen besteht (Protonen, Neutronen).

Die den Atomkern umgebenen Elektronen besitzen nach dem heutigen Stand der Wissenschaft keine innere Struktur mehr, und sind damit bereits echte Elementarteilchen. Die Nukleonen sind jedoch wiederum aus drei (Valenz-)Quarks zusammengesetzt. Dabei ist zu beachten, dass diese Valenzquarks zusätzlich noch von sogenannten Seequarks im Quarksee umgeben sind. Die Seequarks sind virtuelle Quarks- Antiquarks-Paare, die durch die Austauschteilchen der Gluonen erzeugt und gleich wieder vernichtet werden.

Die Elementarteilchen der Teilchenphysik

Neben den relativ stabilen Elementarteilchen gibt es auch noch eine ganze Reihe weiterer, kurzlebiger Teilchen. Insgesamt werden derzeit folgende Teilchen als elementar angesehen:

Fermionen (Konstituenten der Materie):

- 6 Leptonen (u. a . das Elektron)

- 6 Quarks (u. a. Up, Down)

Bosonen (Kräfte, bzw. Wechselwirkungen, also Beziehungen zwischen Fermionen):

- 5 Bosonen (Gluonen ->starke WW, Photonen -> elektromagnetische WW, W- und Z-Teilchen -> schwache WW, Higgs-Teilchen)

- 1 Hypothetisches Boson für die Gravitation (bislang noch nicht nachgewiesen, daher nicht Bestandteil des Standardmodells der Teilchenphysik)

Die Hadronen

In der Natur haben wir es statt mit Elementarteilchen häufig mit zusammengesetzten Teilchen zu tun. Diese nicht mehr fundamentalen Teilchen nennt man Hadronen.

Die Vielfalt der Kombinationsmöglichkeiten von Leptonen und Quarks bringt es nun jedoch mit sich, dass man heutzutage rund 250 verschiedene Hadronensorten kennt, und die man scherzhaft wegen ihrer großen Anzahl auch "Teilchenzoo" nennt.

Die Kopplung von Elementarteilchen zu den Strukturen der Materie

- Gluonen <-> Quarks (asymptotische Freiheitsgrade innerhalb der Quarks)

- W- und Z-Teilchen <-> Quarks

- Photonen <-> Elektronen, Kernteilchen (Protonen, Neutronen)

- Gravitation <-> Raumzeit <-> Materie und Photonen

Im Inneren der Materie finden wir zunächst die kurzreichweitige Kopplung der Quarks über die starke und schwache Wechselwirkung. Eine unendliche Reichweite besitzen dann die elektromagentische WW und die gravitative WW. Während die Photonen jedoch direkt auf die Elektronen und Kernteilchen wirken, wirkt die Gravitation erst durch die Raumzeitkrümmung quasi indirekt auf die Materie oder einzelne Photonen im Universum.

1.4 Systemphysik

Systemphysik ist ein relativ neuer strukturwissenschaftlicher Zweig der Physik, der sich derzeit noch im Aufbau befindet. Er umfasst die Beschäftigung mit komplexen physikalischen Systemen und Prozessen. Es geht dabei konkret um die Erforschung von Vielteilchensystemen, die in nichttrivialer Weise miteinander agieren.

Die entsprechenden Forschungszweige tragen dabei Namen wie beispielsweise "Komplexe Systeme" oder "Nichtlineare dynamische Systeme". In Deutschland gibt es dazu z.B. das Max-Planck-Institut für Physik komplexer Systeme in Dresden (online), das Max-Planck-Institut für Dynamik und Selbstorganisation (online), den Forschungsbereich Komplexe Systeme an der Uni Freiburg (online), die Professur Komplexe Systeme und Nichtlineare Dynamik in Chemnitz (online) und viele mehr.

Anmerkung: Das didaktische Konzept der "Systemphysik" von Werner Maurer zur alternativen Modellierung dynamischer Systeme ist in diesem Zusammenhang jedoch nicht gemeint.

Emergenz

Im Gegensatz zur klassischen reduktionistischen Forschungsansatz, versucht man bei der Erforschung komplexer Systeme die Interaktionen von Vielteilchensystemen zu verstehen, welche dazu neigen, neue qualitative Eigenschaften aus sich selbst heraus hervorzubringen, die in den einzelnen Komponenten und deren Gesetzmäßigkeiten nicht enthalten sind. Das antireduktionistische Forschungsparadigma unterstützt dabei sinnvoll die reduktionistisch gewonnenen Erkenntnisse über die einzelnen Systemelemente.

"Neue Physik" ?

Die Erforschung komplexer physikalischer Systeme erlebte seit dem Ende des 20. Jahrhunderts einen rasanten Aufschwung, der u.a. auch mit den modellbildenden Verfahren der aufstrebenden, leistungsfähigen Informationstechnologie verbunden war.

Ein prominenter Vertreter einer neuen Sichtweise auf die Forschungsgegenstände der Physik ist beispielweise der Nobelpreisträger P. W. Anderson, der 1972 seinen berühmten Artikel "More Is Different" publizierte (online). Vielteilchensysteme weisen demnach neue Eigenschaften auf, die mit Phasenübergängen und Symmetriebrüchen verbunden sind. "Mehr" bedeutet daher physikalisch gesehen gegebenenfalls auch, dass sich Vielteilchensysteme qualitativ komplett "anders" Verhalten. Sie besitzen dann neue Eigenschaften, die sich nicht aus den zugrundeliegenden physikalischen Gesetzen herleiten lassen. Es entsteht vielmehr eine Gesetzespyramide, bei der ein System sowohl den fundamentalen, als auch den emergenten Gesetzmäßigkeiten gehorcht.

Ein Schüler von Anderson, der Nobelpreisträger Robert Laughlin, ist ebenfalls ein prominenter Verfechter der Erforschung emergenter Phänomene im Rahmen der Physik (siehe sein Buch "Abschied von der Weltformel"). Er vertritt sogar die Meinung, dass sämtliche Naturgesetze erst durch kollektives Geschehen emergieren, und nicht umgekehrt die Naturgesetze diese Ordnungsphänomene erzeugen.

Zudem möchte er die Erkenntnismöglichkeiten von reduktionistischen Theorien relativieren. Selbst wenn wir irgendwann einmal eine fundamentale physikalische Theorie für alles hätten (beispielsweise etwas ähnliches wie die Stringtheorie), dann würde uns selbst diese Theorie nur sehr bedingt mehr Erkenntnisse über unsere makroskopische Welt liefern, da wir es dort immer mit komplexen Vielteilchensystemen zu tun haben.

Fundamentale physikalische Größen vs. emergente physikalische Größen

In der Physik gibt es viele Größen, die für einzelne Elementarteilchen gar nicht erst definiert werden können. Beispielsweise die Eigenschaften "nass" (bzw. flüssig), der Druck innerhalb eines Gasvolumens oder die Temperatur eines Gegenstandes. Ein einzelnes Teilchen oder Molekül kann weder nass sein, noch einen Druck bzw. eine Temperatur besitzen. Diese Eigenschaften emergieren erst in Vielteilchensystemen. Genauso verhält es sich mit den Phänomenen der Supraleitung oder der Supraflüssigkeit. Und selbst die 13 kristallinen Formen von Wassereis lassen sich nicht aus der ihnen zugrunde liegenden Quantenphysik herleiten.

Weiterhin sind insbesondere sämtliche Phänomene der Selbstorganisation nicht auf reduktionistische Weise verstehbar. Die physikalische Theorie des Laserlichtes, die zur strukturwissenschaftlichen Theorie der Synergetik führte, ist daher ebenfalls ein emergentes Ordnungsphänomen, dass nur in massiven Vielteilchensystemen auftritt.

Weitere Forschungsgebiete komplexer Systeme beschäftigen sich beispielsweise mit gekoppelten Oszillatoren, der turbulenten Fluid-Dynamik, der Plasmaphysik oder in der Astrophysik mit der gravitativen Dynamik von N Himmelskörpern.

Emergenz von Ordnung und Chaos vs. Reduktionismus

In seinen Buch Abschied von der Weltformel schreibt Laughlin dazu:

"Wir leben nicht in der Endzeit der physikalischen Entdeckungen, sondern am Ende des Reduktionismus. Damit ist nicht gesagt, dass die Gesetzmäßigkeit im mikroskopischen Maßstab falsch sei, oder keinen Zweck habe, sondern nur, dass sie in einer Vielzahl von Umständen durch ihre Kinder und Kindeskinder, die 'höheren' (emergenten) Ordnungsgesetze der Welt, belanglos geworden sind. Wir lassen die Gewohnheit hinter uns, die organisatorischen Wunder der Natur zu trivialisieren, und akzeptieren, dass Ordnung an und für sich bedeutsam ist - in manchen Fällen sogar der bedeutsamste Sachverhalt.

Ein wichtiger Unterschied zwischen dem gegenwärtigen und dem gerade vergangenen Zeitalter ist das Wissen, dass es sowohl sowohl üble als auch gute Gesetzmäßigkeiten gibt.

Gute Gesetze wie Festigkeit oder Quantenchromodynamik bringen mathematische Vorhersagekraft durch Protektion hervor, jene Unempfindlichkeit gewisser gemessener Größen gegenüber Unvollkommenheit der Proben oder Rechen- und Messfehler. Wäre die Welt ein glücklicher Ort, an dem es nur 'gute' Gesetze gäbe, könnten wir die Beherrschung der Natur darauf reduzieren, ausreichend rechenstarke Computer anzuschaffen. Protektion würde alle Fehler ausbügeln. In der Welt, die wir tatsächlich bewohnen, gibt es jedoch eine Fülle 'dunkler' Gesetze, und diese zerstören die Vorhersagekraft, indem sie Fehler verschärfen und dafür sorgen, dass gemessene Größen äußerst empfindlich gegenüber unkontrollierbaren äußeren Faktoren werden. Im Zeitalter der Emergenz kommt es darauf an, nach dunklen Gesetzen Ausschau zu halten.

Ironischer Weise hat gerade der Erfolg des Reduktionismus dazu beigetragen, den Weg für seinen Niedergang zu pflastern. Wie die sorgfältige quantitative Untersuchung mikroskopischer Teile im Lauf der Zeit gezeigt hat, sind Prinzipien kollektiver Ordnung nicht einfach nur kuriose Nebenhandlung, sondern alles - die wahre Quelle physikalischer Gesetzmäßigkeit. Weil unsere Messungen so genau sind, können wir mit Überzeugung erklären, dass die Suche nach einer einzigen ultimativen Wahrheit gleichzeitig aber gescheitert ist."

1.5 Die physikalisch-kosmologische Evolution unseres Universums

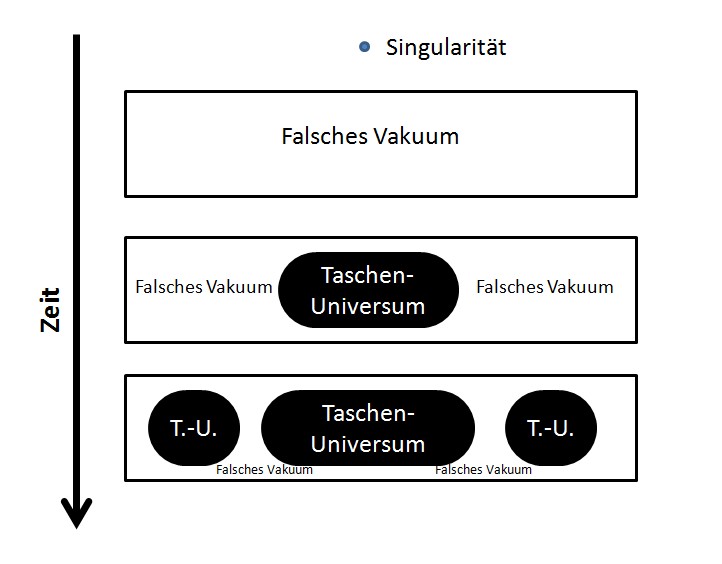

1.5.1 Big Bang, Inflation und unser Universum als "Taschenuniversum" ("Pocket Universe")

Das plausibelste Szenario von der Entstehung unseres Universums ist derzeit das Urknallszenario, wonach sich das Universum quasi aus dem Nichts (Singularität) in eine Raumzeit-Blase katapultierte, dann rasant aufblähte und mit Energie (=Materieenergie) und negativer Energie (=Gravitation) füllte.

Allerdings nicht als Blase innerhalb irgendeines Raumes, sondern diese Blase gebar den Raum selbst, und gleich noch mit dazu die Zeit. Demnach wäre es sinnlos zu fragen, worin sich das Universum befände, oder was eigentlich zeitlich gesehen davor war.

Die ursprüngliche Urknalltheorie, bei dem unser Universum sich "langsam" und linear aus einer Singularität entwickelte, wird heutzutage um die Inflationstheorie ergänzt. Mit Hilfe der klassischen Urknalltheorie hatten die Kosmologen zunächst untersucht, wie sich der frühe Feuerball unseres Universums abkühlte, Atomkerne formte und sich langsam Materienebel und Galaxien bildeten. Alles in allem hat die Urknalltheorie bereits durch viele astronomische Beobachtungen ihre Bestätigung erfahren, aber sie beschrieb trotzdem lediglich die Folgen des Urknalls, nicht jedoch den Knall an sich, oder, wie Alan Guth es formulierte, „was knallte, wie es knallte und weshalb es knallte.“

Die Inflationstheorie birgt jedoch noch einen überraschenden und faszinierenden Aspekt der kosmologischen Evolution. Demnach könnte es sich bei unserem sichtbaren Universum nur um einen winzigen Teil eines viel größeren Raumzeitbereiches handeln. In der inflationären Kosmologie geht man davon aus, dass sich das Universum aus einer Anfangssingularität aus einem winzigen, sogenannten "Falschen Vakuum" heraus entwickelt hat. Der Begriff des Falschen Vakuums stammt übrigens nicht aus der Kosmologie, sondern aus der Hochenergie-Teilchenphysik. Dort untersucht man im Rahmen der Quantenphysik verschieden energiereiche Vakuumszustände. Hochenergetische Vakua werden als "Falsche" Vakua bezeichnet, da sie anders als unser heutiges "echtes" Vakuum höchst instabil sind. Nach einer sehr kurzen Zeitspanne (innerhalb eines Bruchteils einer Sekunde) zerfällt ein Falsches Vakuum in das Echte, wobei die überschüssige Energie in einem Feuerball aus Elementarteilchen freigesetzt wird.

Wenn ein Vakuumszustand jedoch Energie besitzt, muss er, das wissen wir von Einstein, auch Spannung (= negativer Druck) haben. Spannung bewirkt eine abstoßende Gravitation. Und mit genau mit dieser repulsiven Kraft gelingt es der Inflationstheorie, das frühe Universum quasi aus seiner Singularität "hinauszusprengen". Da diese Raumbereiche jedoch instabil sind, zerfällt das Falsche Vakuum dann lokal, und bildet eine Blase, die dann ein echtes Vakuum und Elementarteilchen besitzt, und sich von da an "nur" noch mit annähernder Lichtgeschwindigkeit ausbreitet. Das Falsche Vakuum kann jedoch mit Überlichtgeschwindigkeit expandieren. Da nun der Neubildungsprozess des Falschen Vakuums schneller als der Zerfallsprozess ist, könnten sich theoretisch in dem Ozean des Falschen Vakuums ständig neue "Insel-Universen", gleichsam wie Blasen in einem Kochtopf bilden. Da sich der Zwischenraum zwischen ihnen mit Überlichtgeschwindigkeit ausdehnt, können diese Inseln jedoch niemals in einem kausalen Zusammenhang zueinander stehen, also keine gegenseitigen Wechselwirkungen ausüben. Guth nannte solche Universums-Inseln "Pocket-Universe", also "Taschenuniversum", da sie nur begrenzte Raumbereiche innerhalb des viel größeren Ozeans des Falschen Vakuums darstellen.

Bildlizenz-Info: Taschenuniversum; Bild selbst

erstellt; public domain

Es ist ein äußerst faszinierender Gedanke, dass wir selbst sozusagen nur in einem "kleinen" Taschenuniversum leben, während um uns herum in einem schon fast absurd gewaltig großen Ozean von Falschem Vakuum ständig neue Universums-Inseln "hervorblubbern". Für unser lokales Taschenuniversum endet die Geschichte der Inflation jedoch mit dem Zerfall des falschen Vakuums, und unsere lokale kosmologische Evolution setzte ein, die innerhalb der nächsten 13,8 Milliarden Jahre, ausgehend von den Elementarteilchen, viele weitere interessante Strukturen hervorbringen sollte.

Abschließend sei jedoch noch auf die Idee von Guth hingewiesen, dass es sich bei unserem Universum, bzw. den vielen Taschenuniversen im Prinzip um ein ultimatives Freispiels handeln könne, da man fast Nichts braucht, um sie herzustellen. Zur mathematischen Herleitung dieses winzigen "Samenkorns" für unser Universum ist es entscheidend, dass der Radius dieser Sphäre Falschen Vakuums über dem kritischen Wert liegt, der wiederum von der Energiedichte des Vakuums abhängt. Die moderne Teilchenphysik hat bislang die Existenz des sogenannten elektroschwachen Vakuums nachgewiesen und dessen Energiedichte ermittelt. Ursprünglich muss es in der Universumsentwicklung vorher jedoch noch viel energiereichere Vakua gegeben haben, die man zwar noch nicht nachweisen, jedoch bereits theoretisch berechnen kann. Das Große Vereinheitliche Vakuum, dass drei der vier fundamentalen Wechselwirkungen zusammenführt kann derzeit bereits plausibel hergeleitet werden, das Vakuum, in dem aller vier Grundkräfte vereint sind, besitzt noch hochspekulativen Charakter. Berechnungen ergeben nun, dass beim Elektroschwachen Vakuum eine Blase von einem Millimeter nötig gewesen wäre, beim Großen Vereinheitlichten Vakuum ist dieser Radius jedoch aufgrund der viel höheren Energiedichte bereits um den sagenhaften Faktor von 10 Billionen kleiner. Mehr braucht es also nicht, als dieses winzige "Fast-Nichts", um ein Universum zu erschaffen. Und neben diesem räumlich winzigen Anfangsbereich war auch die Energiemenge ursprünglich nur extrem klein (wie es dann zu den großen Energiemengen kam, ohne den Energieerhaltungssatz zu verletzen wurde bereits im Punkt 1.2.1 beschrieben). Wahrhaft ein ziemlich ultimatives Freispiel, oder?

1.5.2 Entstehung und Strukturen im Raum und Sternenentstehung

Nach dem Urknall und der inflationären Phase dehnte sich das Universum "nur" noch mit Lichtgeschwindigkeit immer weiter aus und kühlte dabei ab.

Doch bei gleichmäßiger Massen(bzw. Energie-)verteilung kommt es auch bei Expansion nicht zur Entstehung von Strukturen. Hohe Temperaturen und damit hohe Geschwindigkeiten in den Teilchenbewegungen sorgen dafür, dass zufällig entstandene lokale Dichtefluktuationen schnell ausgeglichen werden. Strukturbildung setzt einen Symmetriebruch voraus.

Im inflationären Urknall-Modell wurden deshalb Symmetriebrüche innerhalb der inflationären Phase eingeführt, die bereits zur Entstehung von regionalen Dichteunterschieden führen. Diese werden dann als Anfänge der kosmischen Strukturbildung interpretiert.

Jenseits von kritischen Dichtefluktuationen sorgen bei hinreichend großer Masse die Gravitationskräfte für eine Verstärkung der Massenseparation. Massereiche Regionen ziehen Materie aus der Umgebung stärker an. Dadurch werden sie schwerer, während die Umgebung Masse verliert. Dieser Vorgang besitzt eine positive Rückkopplung. Je dichter und schwerer ein lokaler Bereich wird, umso stärker ist die durch ihn ausgeübte Gravitationswirkung auf andere Massen, und umso schneller kann er anwachsen.

Dieser Prozess läuft auch heute noch in unserem Universum mit extrem verdünnter Materie im Weltall ab, und zwar in den Gas- und Staubwolken. Interstellare Staubwolken haben zum Teil Ausdehnungen von Lichtjahren und können, obwohl die Dichte sehr niedrig ist, trotzdem kontrahieren, so dass eine Sternbildung einsetzt. Letztlich entscheidet das Verhältnis von Gravitation und thermischer Anregung über die Kontraktion oder Ausbreitung einer Materiewolke.

Erste Sterne im Universum

Die Materie des frühen Universums bestand überwiegend aus Wasserstoff, also der Verbindung eines Protons mit einem Elektron. Mit zunehmender Kontraktion von solchen Wasserstoffwolken heizen sich diese auf, da bei der Kontraktion ihre potentielle Energie in kinetische (also thermische) umgewandelt wird. Der Temperaturanstieg führt zunächst zur Ionisation, d. h. die Protonen trennen sich wieder von ihren Elektronen, und bei weiterem Temperaturanstieg können die aufeinandertreffenden Protonen oberhalb einer kritischen Dichte miteinander verschmelzen, was zur Kernfusion von Wasserstoffkernen zu Heliumkernen führt. Die ersten Sterne wurden geboren.

Die durch die Dichtefluktuationen ausgelöste Strukturbildung und die Entstehung von vielen Sternen sorgte damit auch für einen drastischen Symmetriebruch in der Temperaturverteilung im Universum. Ausgedehnte dünne, kalte Gebiete standen auf einmal enger begrenzten, dichten, heißen Gebieten gegenüber.

1.5.3 Entstehung der chemischen Elemente als verschiedene Atomarten (Nukleide)

Kurz nach dem Urknall lag die Bildung von chemischen Elementen, d. h. die Entstehung von verschiedenen Atomarten noch in weiter Ferne. Es gab weder Atome, noch "Licht" als freie elektromagnetische Strahlung. Denn bei ausreichend hohen Temperaturen übertrifft die thermische Energie die der elektrostatischen Wechselwirkung zwischen entgegengesetzt geladenen Teilchen. Daher können sich Elektronen nicht dauerhaft an Protonen oder andere Atomkerne binden. Es liegt ein thermisches Plasma vor. Außerdem besteht ein energetisches Gleichgewicht zwischen den Photonen und der Bewegung der massebehafteten Teilchen. Die hohe Dichte von elektrischen Ladungsträgern sorgt dafür, dass Photonen sich nicht als Lichtstrahlen ausbreiten können. Der Kosmos ist in diesem Zustand nicht transparent. Photonen bewegen sich eher wie diffundierende Teilchen.

Mit der Expansion des Weltalls verringerte sich jedoch sowohl die Dichte als auch die mittlere Temperatur des thermischen Plasmas. Dadurch wurde das Gleichgewicht zwischen gebundenen und freien Elementarteilchen in Richtung der gebundenen Elementarteilchen verschoben. In einem relativ kurzen Zeitraum dominierten dann die ersten Atome (hauptsächlich Wasserstoff, sowie kleinere Mengen Helium und Lithium) gegenüber den freien Ladungsträgern.

Gleichzeitig verschob sich das Intensitätsmaximum der Strahlung zu immer größeren Wellenlängen hin. Die Atome absorbierten nur Photonen, mit denen sie in Resonanz waren. Photonen mit dazwischen liegender oder geringerer Energie konnten ihre Energie nicht mehr an die Teilchen abgeben. Photonen und die massebehaftete Materie wurden energetisch entkoppelt und Strahlung konnte sich ausbreiten. Das Weltall wurde nun transparent (und zwar erst rund 300.000 Jahre nach dem Urknall).

Wasserstoff und Helium

In der ersten Sternengeneration kam es zunächst per Kernfusion zur Bildung von Helium aus dem bereits vorhandenen Wasserstoff. Für die stellare Kernfusion existieren grundsätzlich zwei Mechanismen: Der Proton-Proton-Mechanismus und der Kohlenstoff-Stickstoff-Zyklus, der deutlich effektiver ist. Da es im frühen Universum jedoch zunächst noch keinen Kohlenstoff gab, verwendeten die Sterne der ersten Generation den Proton-Proton-Mechanismus. Der zweite Mechanismus wurde erst ab der zweiten Sternengeneration wirksam.

Die Bildung mittelschwerer Elemente

Ein Stern der ersten Generation kann jedoch nicht nur Helium durch fusionsgetriebene Elementumwandlung erzeugen. Denn wenn das "Wasserstoffbrennen" sich dem Ende zuneigt, wird das Gleichgewicht des Sterns gestört, dass aus der nach innen gerichteten Gravitationskraft, und dem nach außen gerichteten Strahlungsdruck des Fusionsprozesses besteht. Daher steigt der innere Druck in einem Stern nach dem Wasserstoffbrennen gravitationsbedingt so stark an, dass es bei ausreichender Masse des Sterns dann zum Heliumbrennen kommen kann. Es entstehen dadurch nun vor allem Kohlenstoffkerne.

Erlischt das Heliumbrennen, kann es abermals zur Kontraktion des Sterns und zur Zündung weiterer Fusionsprozesse kommen. Dabei entstehen zunächst hauptsächlich Stickstoff und Sauerstoff. Insbesondere die Isotope 16O und 12C zeichnen sich durch eine extrem hohe Stabilität aus. Deshalb ist es nicht überraschend, dass Kohlenstoff und Sauerstoff neben Wasserstoff und Helium die häufigste Elemente im Universum sind. Doch auch der Stickstoff ist verhältnismäßig stabil und stellt das fünfthäufigste Element dar. Insgesamt können durch Fusionsprozesse relativ leicht die Elemente der zweiten Periode des Periodensystems gebildet werden.

Mit Blick auf die stoffliche Grundlage des Lebens auf der Erde ist es bemerkenswert, dass es im Weltall an den Elementen, die den Hauptbestandteil in den organischen Verbindungen bilden, die Lebewesen aufbauen, nämlich Kohlenstoff, Wasserstoff, Sauerstoff und Stickstoff, nicht mangelt.

Die Entstehung schwerer Elemente

Die Bildung von Elementen oberhalb der zweiten Periode des Periodensystems erfolgt durch weitere Integration von Protonen und Neutronen zu Atomkernen. Mit wachsender Ordnungszahl wächst jedoch auch die für die entsprechende Fusion nötige Aktivierungsenergie, so dass schwerere Elemente nur in Sternen größerer Masse entstehen.

So ein Stern muss die Fähigkeit besitzen, das Sauerstoffbrennen zu zünden. Bei hinreichend großer Masse kann die notwendige Aktivierungsbarriere überschritten werden und es bilden sich die Elemente der dritten Periode. Kann ein Stern dann auch noch die Aktivierungsgrenze für das Siliziumbrennen überschreiten, bilden sich sogar einige Elemente der 4. Periode. Doch hier erfolgt dann ein recht abrupter Abriss in der Elementbildung durch die Kernfusion. Bis zum Atomgewicht (Massenzahl) von 56, also dem Eisen, ist jede Kernfusion exotherm, liefert also mehr Energie, als für die Aktivierung notwendig ist. Besitzt ein Kern jedoch mehr als 56 Nukleonen (Protonen und Neutronen), wird bei der Fusion von Kernen keine Energie mehr abgegeben, sondern es muss Energie zugeführt werden. Eine komplette Umkehr des Mechanismus also! Während exotherme Prozesse sich nach dem Start selbst unterhalten, laufen endotherme Prozesse nur ab, wenn dabei ständig Energie zugeführt wird.

Die Bildung schwererer Elemente als Eisen, also beispielsweise Kupfer oder Gold, ist deshalb an einen speziellen energieliefernden Prozess gebunden, und kann daher in normalen Sternen im Rahmen von Fusionsprozessen nicht ablaufen. Nach den heutigen Vorstellungen ist wahrscheinlich nur eine Supernovaexplosion in der Lage, die für die Bildung der besonders schweren Elemente nötigen Energien bereitzustellen. Supernovaexplosionen sind brachiale Vorgänge, die sich am Ende der Lebensdauer besonders massereicher Sterne abspielen. Während Fusionsprozesse sich über Milliarden von Jahren hinziehen können, wird die Energie einer Supernovaexplosion innerhalb von Tagen freigesetzt. Die Strahlungsintensität dabei ist so groß, dass ein entsprechender Stern für kurze Zeit mehr Strahlungsleistung abgibt, als die gesamte ihn umgebende Galaxis! Eine in unserer Galaxie stattfindende Explosion konnte daher bereits in der Frühzeit der Menschheitsgeschichte sogar mit bloßem Auge beobachtet und aufgezeichnet werden.

Da unsere Erde und mit ihr auch die anderen Planeten, die Monde und unsere Sonne schwere Elemente (also Elemente deutlich oberhalb von Eisen) enthalten, muss die Materie, aus der unser Sonnensystem besteht, schon mindestens einen Synthesezyklus innerhalb einer Supernova durchlaufen haben. Unsere Sonne ist daher ein Stern der zweiten oder einer späteren Generation.

Es mag zunächst ein wenig befremdlich wirken, die Bausteine unsers heutigen Sonnensystems und auch die Bausteine unseres eigenen Körpers quasi als "Ausscheidungsprodukt" einer früheren Supernovaexplosion, also eines kosmischen Metabolismus, zu betrachten. Doch es ist auch ein faszinierende Gedanke sich vorzustellen, dass das Silber, Platin oder Gold in unserem Schmuck, oder das Jod in unserem Körper einst in einem so spektakulären kosmologischen Prozess entstand, und wir damit untrennbar in die Geschichte unseres Universums hineinverwoben sind.

Doch mit der Geschichte der Elemententstehung, also der Entstehung der elementaren Atomarten, endet noch lange nicht die strukturwissenschaftliche Reise in die Möglichkeiten unseres Universums, Strukturen zu kreieren. Sie fängt vielmehr damit gerade erst an! Doch was Atome eigentlich wiederum verbindungstechnisch so alles treiben können, wenn der Tag lang ist, das ist jedoch eine andere Geschichte. Es handelt sich dabei dann nämlich um die interessanten Gebiete der Wissenschaften der Chemie und der Biologie.

2. Chemie

Chemie ist die Lehre vom Aufbau, Verhalten und der Umwandlung von Stoffen sowie den dabei geltenden Gesetzmäßigkeiten. Als Stoffe gelten in der Chemie entweder Atome, Moleküle oder Ionen.

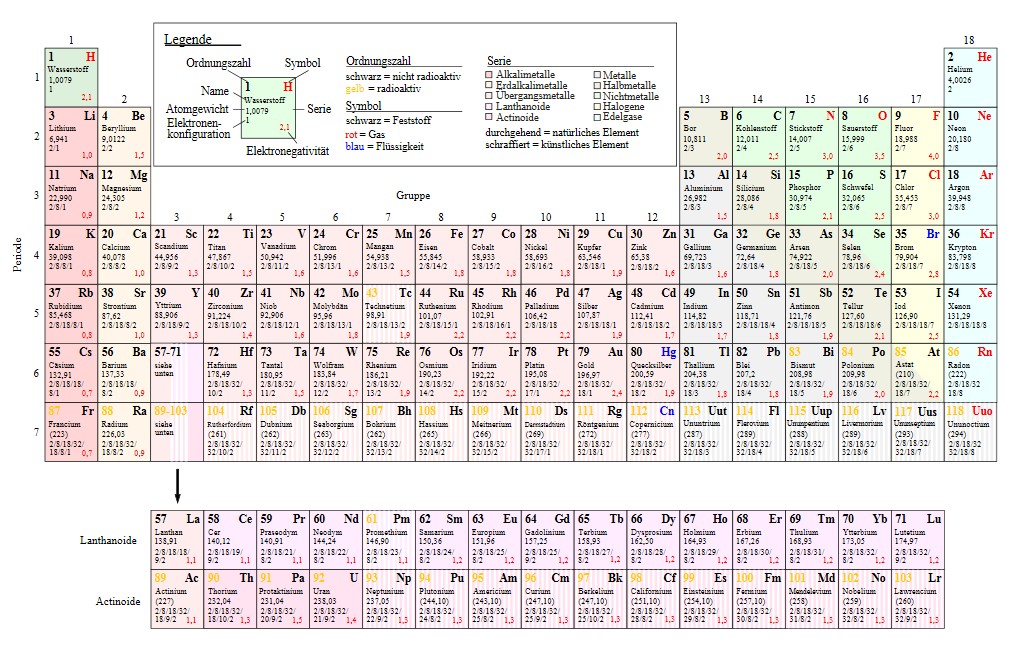

2.1 Die chemischen Elemente des Periodensystems

Die Basis für die Chemie liefert die Physik, welche den Chemikern durch die kosmologische, physikalische Elementbildung und Elementumwandlung insgesamt über 100 verschiedene "Atomsorten" bereitstellt.

Diese, aus Sicht der Physik bereits in ihrem inneren Aufbau recht komplex strukturierten Gebilde, werden in der Chemie dann zu deren "Elementen", also den elementaren Bausteinen, die innerhalb der Chemie nicht weiter auf ihren inneren Aufbau hin untersucht werden.

Die Elementumwandlungen, die in der mittelalterlichen Allchemie noch im Mittelpunkt vieler "chemischer" Versuche standen (vorzugsweise die Umwandlung von unedlen Metallen in Gold), sind aus der modernen Chemie verschwunden. Chemiker begreifen heutzutage Elementumwandlungen als rein physikalische Prozesse, und damit liegen sie sozusagen außerhalb der Zuständigkeitsbereiches eines modernen Chemikers. Wenn in der Chemie Stoffumwandlungen von Atomen stattfinden, dann nur den dem Sinne, dass beispielsweise aus einer Menge von zwei verschiedenen Atomsorten Moleküle entstehen, oder umgekehrt aus Molekülen Atome synthetisiert werden.

Alle Vorgänge der Chemie spielen sich daher nicht innerhalb von Atomen ab, sondern betreffen lediglich die äußere Elektronenhülle der Atome. Ein Chemiker verschiebt quasi lediglich Elektronen.

Das Periodensystem als Ordnungssystem der chemischen Elemente

Bildlizenz-Info: Periodic Table German,

Wikimedia, Public Domain

2.2 Die Moleküle und deren Bindungsarten (Atom-, Ionen- und Metallbindung)

Alle Erkenntnisgegenstände, die sich nicht mit den elementaren chemischen Eigenschaften der chemischen Elemente beschäftigen, dienen der Erforschung von zusammengesetzten Elementen, also Gebilden, die aus mehreren miteinander verbundenen Atomen bestehen. Es sind dies die chemischen Moleküle, welche durch ganz verschiedene Arten von Bindungen mehrerer Atome aneinander entstehen.

- die Atombindung (kovalente Bindung)

- die Ionenbindung

- die Metallische Bindung

Sonderfälle:

- die Van-der-Waalsche Bindung (Orientierungs- und Dispersionskräfte unipolarer Moleküle)

- die Wasserstoffbrückenbindung (sorgen für die Struktur des Wassers und sind für die biologischen Eigenschaften von Proteinen und Nukleinsäuren verantwortlich)

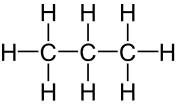

2.3 Die Strukturtheorie der Chemie

Bis zur Mitte des 19.Jahrhunderts gab es in der Theorie der Chemie einen wissenschaftlichen Streit darum, durch welche Systematik sich die Eigenschaften und der Aufbau der chemischen Moleküle am besten ableiten lassen. Zur Diskussion standen die Radikal- die Typen- und die Strukturchemie. Insbesondere durch die bahnbrechenden Arbeiten von Kekulé zu den Benzolringen der organischen Chemie wurde die Chemie bis spätestens im Jahre 1870 zur Strukturchemie revolutioniert und damit letztlich auch den Siegeszug der "Strukturalisten" eingeläutet. Seit dem erklären sich die chemischen Eigenschaften aus der inneren Struktur der Moleküle. Ebenso schuf die Strukturchemie eine größere Nähe zur Physik, die ein besseres Verständnis der Verbindungsfähigkeiten der Atome bot. 6

Neben der bekannten Summenformel (z. B. "H2O") besteht die Aufgabe eines Chemikers auch darin, eine entsprechende Strukturformel aufzustellen. Diese sieht dann beispielsweise so aus:

Bildlizenz-Info: Wikimedia (Propan_Lewis);

public domain

Die meisten chemischen Disziplinen fokussieren sich dabei auf ein einzelnes Molekül: Es mag das Ziel einer Synthese oder eines biochemischen Isolationsprozesses sein, bedarf struktureller Aufklärung oder einer detaillierten Analyse des Moleküls mit theoretischen Methoden. Eine solche inhaltliche und methodische Fokussierung erreicht jedoch ihre Grenze, wenn Systeme betrachtet werden, in denen chemische Spezies miteinander reagieren. Speziell dafür hat sich inzwischen der Zweig der Systemchemie entwickelt.

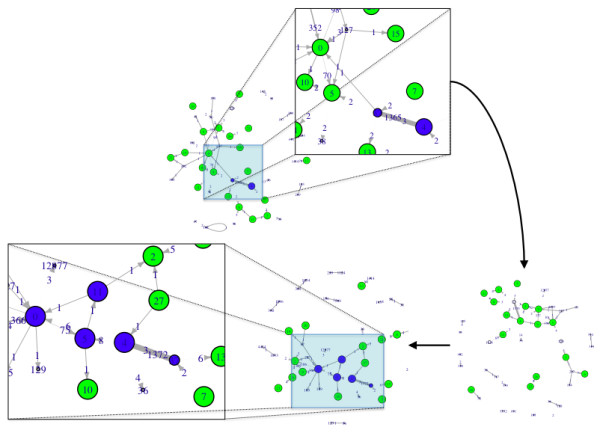

2.4 Systemchemie

Das Gebiet, das sich mit der Analyse und dem Design von dynamischen Phänomenen in komplexen chemischen Systemen beschäftigt, heißt Systemchemie (engl. "Systems Chemistry"). Hierbei ist im Gegensatz zur klassischen Synthesechemie die Präsenz und Charakterisierung der Substanzen nur die Voraussetzung, denn Ziel ist es, das makroskopische Verhalten des Systems über mikroskopische physikochemische Parameter zu verstehen. Dabei geht es u. a. darum, autokatalytische Reaktionssysteme zu untersuchen und Methoden für ihre Integration in dynamische Supersysteme zu entwickeln. Systemchemie bildet damit den Gegenpol zur traditionellen reduktionistischen Herangehensweise an chemische Probleme, indem sie mehrere Variablen gleichzeitig und nicht nur isoliert voneinander studiert.

Beispiele für komplexe chemische Systeme sind dynamische kombinatorische Bibliotheken, oszillierende Reaktionen, chiraler Symmetriebruch, und Netzwerke autokatalytischer oder selbstreplizierender Spezies. Diesen Systemen ist gemeinsam, dass ihr Verhalten ausschließlich aus der Interaktion der zugrunde liegenden Komponenten, aber nicht aus ihren isolierten Eigenschaften resultiert. Um dynamische Phänomene zu verstehen, sind oft Computerprogramme notwendig für Aufgaben wie die Datenextraktion und -reduktion, die Optimierung theoretischer Modelle anhand experimenteller Daten und die Berechnung von Reaktionsenergieprofilen. Dafür existiert selten eine maßgeschneiderte Lösung, so dass ein Chemiker die entsprechende Software selbst schreiben oder eine bestehende modifizieren muss.

Kinetische Modellierung in der Systemchemie

Die Kinetik und Thermodynamik chemischer Reaktionssysteme, die über Rückkopplungsmechanismen verfügen, ist oft nicht trivial: In selbstreplizierenden Systemen kann es zum Beispiel durch die Wechselwirkung mehrerer Template zu Konkurrenz- oder Kooperations-Szenarien kommen; dynamische kombinatorische Bibliotheken zeigen trotz Gleichgewichtsbedingungen unter Umständen nicht die Amplifikation der stabilsten Spezies. Beide Phänomene kombiniert führen zu einem System, das teilweise thermodynamisch und teilweise kinetisch kontrolliert ist. Die Konstruktion eines Reaktionsmodells, das die gekoppelten elementaren Prozesse adäquat beschreibt, ist in vielen Fällen eine Herausforderung und erfordert im ersten Schritt physikochemisches Know-how. Im zweiten Schritt ist das Modell anhand experimenteller Daten wie zeitaufgelösten Konzentrationen oder chemischen Gleichgewichten zu simulieren und zu optimieren. Dazu muss ein Computerprogramm ein Reaktionsmodell in chemische Ratengleichungen übersetzen, diese numerisch integrieren und Parameter wie Geschwindigkeits- und Gleichgewichtskonstanten so optimieren, dass Simulation und Experiment übereinstimmen (siehe beispielsweise Simfit von Günter von Kiedrowski).

Die Systemchemie verlangt, Chemie nicht nur aus einer mechanistischen, sondern auch aus einer mathematisch-dynamischen Perspektive heraus zu verstehen.

Bildlizenz-Info: Filisetti et al. Journal of

Systems Chemistry, 2011; Public Domain

Molecular Modelling der Systemchemie

Um theoretische Rechnungen ergänzte experimentelle Daten sind wegen der Leistungsfähigkeit moderner Computer und vielen verfügbaren Programmen gängige Praxis. Für die Systemchemie besitzen die daraus gewonnenen Erkenntnisse besonderen Wert, da die Komplexität der zu analysierenden Systeme die Erhebung experimenteller Daten manchmal erschwert oder unmöglich macht.

Die typische Anwendungsbreite erstreckt sich für den Chemiker von der Berechnung optimierter Geometrien, über Energien von Grund- und Übergangszuständen sowie Orbitalen bis zu Eigenschaften wie magnetischen Abschirmungskonstanten oder Absorptionsbanden für die UV- oder IR- Spektroskopie. Für die Entwicklung der Systemchemie ist es wichtig, nicht nur die Methoden zu nutzen, die unter experimentell arbeitenden Chemikern etabliert sind, sondern auch den Werkzeugkasten theoretischer Methoden zu erweitern, um der steigenden Komplexität der untersuchten Systeme gerecht zu werden.

Ein Beispiel findet sich in der Analyse eines selbstreplizierenden Systems. Die theoretischen Physiker Chris D. Lorenz und Nikos L. Doltsinis vom King's College London halfen, mit Ab-initio-Molekulardynamik- Simulationen (AIMD) Freie-Energie-Profile für alle ablaufenden Reaktionen zu berechnen. Die Profile erklärten das beobachtete Reaktionsverhalten. Ein Vergleich mit Ergebnissen aus statischen Rechnungen, die bisher für derartige Systeme angewendet wurden, zeigte, dass diese Rechnungen die Produktverteilung qualitativ falsch voraussagten.

Interdisziplinäre Methoden

Was genau Systemchemie in zehn Jahren sein wird, ist nicht abzuschätzen. Ob Phänomene wie Selbstreplikation, Selbstorganisation, Oszillationen oder chiraler Symmetriebruch, die momentan als exotische Ausnahme betrachtet werden, tatsächlich selten oder doch häufig, aber in vielen Fällen unentdeckt sind, wird sich zeigen. Unabhängig von der Art weiterer Entdeckungen wird Systemchemie viel Raum für neue Methoden bieten, die zum Teil der Physik, Biologie, Informatik und Theorie komplexer Systeme entliehen sein werden. Ihr interdisziplinärer Ansatz verlangt ein vielfältiges Wissen und mag eine anfängliche Hürde darstellen, ist aber in der Lage, Wissenschaftler verschiedenster Gebiete zu integrieren und unsere heutige Sichtweise der Chemie zu ändern.

2.5 Die chemische Evolution der Moleküle und Elemente im Universum

2.5.1 Die Bildung chemischer Verbindungen: Molekülbildung in heißen und kalten Plasmen im All

Bei hohen Temperaturen liegen alle Stoffe in Form von Plasmen vor. In Abhängigkeit von er Art der Aktivierung gibt es thermische und kalte Plasmen. Oberhalb von Temperaturen, die der Bindungsenergie zwischen Atomen entsprechen, zerfallen Moleküle und Festkörper in Atome. Die Atome selbst verlieren die am schwächsten gebundenen, d. h. die äußeren Elektronen.

Da die Atome Elektronen verloren haben, liegen sie als Kationen vor. Die Zahl der für das Zustandekommen von chemischen Bindungen zuständigen Elektronen ist reduziert. Unter Umständen sind sogar gar keine Außenelektronen mehr vorhanden, die sich an Bindungen beteiligen könnten. Die Konsequenz ist, das Atome in den Plasmen viel weniger ihre spezifischen chemischen Eigenschaften in der Wechselwirkung mit anderen Teilchen einbringen können.

Mit der Abkühlung der Plasmen sinkt jedoch der Ionisierungsgrad und es kommt zu Bildung von Molekülionen und Molekülen. Aus Wasserstoffatomen bilden sich dann beispielsweise Wasserstoffmoleküle (H2).

Die Gesetze, nach denen Atome und Ionen miteinander in Wechselwirkung treten werden nach den Regeln der Quantenmechanik bestimmt und sind in diesem Sinne universell. Insofern sind auch die chemischen Eigenschaften der Ionen und Atome überall in Universum gleich. Dennoch kommt es in All für uns zunächst zu ungewohnten chemischen Reaktionen, da auf der Erde keinerlei Chemie in thermischen Plasmen stattfindet. Die Reaktionen auf der Erde laufen bei moderaten Temperaturen ab, oder in der Industrie werden kalte Plasmen verwendet.

Die chemischen Spezies, die durch plasmachemische Prozesse in den großen Gaswolken im Universum gebildet werden, lassen sich aufgrund ihrer spektralen Eigenschaften identifizieren. Es konnte damit bereits eine recht große Anzahl an chemischen Verbindungen nachgewiesen werden. Dabei findet man auch Spezies, die in unserer normalen irdischen Umwelt nicht, oder mur in sehr geringer Konzentration vorkommen:

-

exotische Moleküle: OH-Radikal, HCO-Radikal, CN-Radikal; SO+-Radikal, CO+-Radikal; H3O+-Ion, HCS+-Ion, ...

-

"normale" anorganische Moleküle: H2O (Wasser), NH3 (Ammoniak), CO (Kohlenmonoxid), ...

-

organische Moleküle: CH3OH (Methanol), C2H4 (Ethylen), ...

Eine vollständige Liste aller im All bislang entdeckten Moleküle findet man in der CDMS-Datenbank (online). Es sind insgesamt rund 180 verschiedene Moleküle (Stand 2013), von denen die meisten nur eine Teilchenzahl von maximal 12 besitzen (mit Ausnahme der Fullerene, die bis zu 70 Atome enthalten).